计算机体系结构前言概述 数据处理的核心基石

计算机体系结构,作为计算机科学的基石之一,定义了计算机系统的抽象模型、功能特性以及各组件间的交互方式。它不仅是硬件设计与软件开发的交汇点,更是理解现代计算技术如何高效处理数据的关键入口。在数字化浪潮席卷全球的今天,数据处理能力已成为衡量计算机系统性能的核心标尺,而这一切都深深植根于体系结构的设计哲学与工程实现之中。

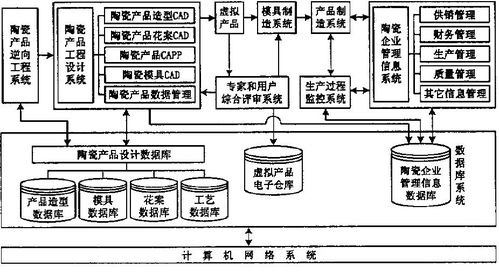

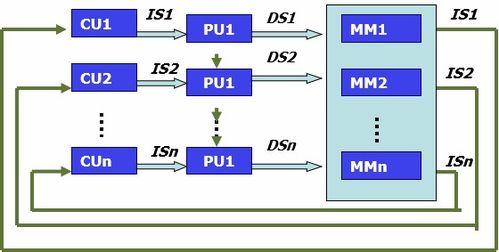

从宏观视角看,计算机体系结构主要围绕数据流与控制流展开。其经典模型通常包括中央处理器(CPU)、存储器、输入/输出系统以及互联这些组件的总线结构。CPU作为“大脑”,负责执行指令、进行算术与逻辑运算;存储器层次结构(从高速缓存到主存再到辅存)则承担着数据与指令的存储与调度任务,其速度与容量的权衡直接决定了数据访问的效率。输入/输出系统则负责计算机与外部世界(如磁盘、网络、用户界面)的数据交换。这些组件通过精密的协作,共同完成了从数据输入、处理到结果输出的完整链条。

数据处理,作为计算机体系结构最核心的使命,其演进历程深刻反映了技术发展的轨迹。早期计算机采用简单的顺序执行模式,数据处理能力受限于单一线程与较低的时钟频率。随着集成电路技术的飞跃,体系结构设计开始追求并行化与专业化:从指令级并行(如流水线、超标量技术)到数据级并行(如SIMD指令集),再到线程级并行(多核、众核处理器),以及当前蓬勃发展的领域专用架构(如GPU用于图形与AI计算,TPU用于张量处理)。这些创新无不旨在突破数据处理在速度、能耗与任务适应性上的瓶颈。

尤其值得注意的是,存储器体系结构对数据处理的影响日益凸显。“内存墙”问题——即处理器速度远超内存访问速度——促使了高速缓存技术的精细化与新型非易失性存储器的引入。面对大数据与人工智能应用的海量数据吞吐需求,内存计算、近存计算等新范式正被积极探索,试图将处理能力更贴近数据存储位置,从而减少数据搬运带来的延迟与能耗。

现代计算机体系结构已不再局限于单机范畴。分布式系统、云计算架构以及边缘计算模型,将数据处理任务分散到由网络连接的众多计算节点上,形成了层次化、协同化的庞大处理网络。体系结构的设计必须考虑数据在节点间的迁移、一致性维护以及负载均衡等复杂问题。

随着量子计算、神经形态计算等非传统计算模型的兴起,计算机体系结构正站在新一轮变革的前夜。这些新型架构有望以迥异于传统冯·诺依曼模型的方式处理信息,为解决特定类别问题(如优化、模式识别)带来指数级的效率提升。无论架构如何演变,其核心目标始终如一:更高效、更智能、更可靠地处理数据,将原始数据转化为有价值的洞察与行动力,驱动人类社会不断向前。

因此,深入学习计算机体系结构,不仅是掌握计算机如何工作的钥匙,更是理解数据处理本质、预见未来技术方向的必修课。它要求我们兼具硬件的严谨与软件的灵动,在逻辑门与算法之间,构筑起支撑数字世界的宏伟蓝图。

如若转载,请注明出处:http://www.k12-xueyeceping.com/product/44.html

更新时间:2026-02-24 03:21:22